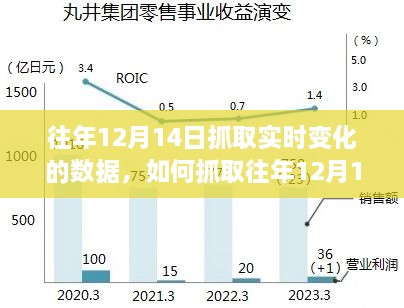

摘要:想要抓取往年12月14日的实时变化数据,可以通过以下步骤实现:确定数据源头,如官方网站、API接口等;使用爬虫技术或相关软件工具,如Python的requests库等,设置时间参数为往年12月14日进行精准抓取;处理并存储抓取到的数据。详细步骤包括确定数据源、编写爬虫程序、设置时间参数、数据存储等。遵循这些步骤,可成功获取往年12月14日的实时变化数据。

一、前言

对于数据分析和市场研究的初学者及进阶用户来说,抓取特定日期,如往年12月14日的实时变化数据,是一项非常重要的技能,本文将指导读者完成这个任务,确保读者能够顺利获取所需数据,本文的内容适合所有水平的读者,无论您是数据分析新手,还是有一定基础的数据挖掘者。

二、准备工作

1、确定数据源:您需要确定要抓取数据的来源,常见的数据源包括政府公开数据、行业报告、社交媒体平台等,对于实时变化数据,社交媒体平台或新闻网站可能是更好的选择。

2、安装必要工具:根据您的数据源,可能需要安装一些数据抓取工具,如Python的Scrapy框架、BeautifulSoup库等,确保您的计算机上已经安装了这些工具。

三、具体步骤

1、选择目标网站:找到包含往年12月14日实时变化数据的网站,这通常是一些新闻网站或社交媒体平台。

2、分析网站结构:打开网站并找到您想要抓取的数据所在的页面,了解页面的HTML结构,这将有助于您确定如何抓取数据。

3、编写爬虫代码:根据您选择的数据源和工具,编写数据抓取代码,对于初学者,可以使用简单的Python脚本和BeautifulSoup库开始,如果您已经熟悉Python和Scrapy框架,可以使用更高级的方法,以下是一个简单的Python示例代码片段:

import requests

from bs4 import BeautifulSoup

目标网站的URL

url = '目标网站的URL'

发送HTTP请求获取网页内容

response = requests.get(url)

使用BeautifulSoup解析网页内容

soup = BeautifulSoup(response.text, 'html.parser')

找到包含数据的HTML元素并提取所需信息

data_elements = soup.find_all('目标元素的标签名') # 根据实际情况替换标签名

for element in data_elements:

# 提取数据并处理(例如日期、内容等)

data = element.text # 获取元素文本内容

# 进一步处理数据...这只是一个简单的示例,实际的数据抓取可能会更复杂,需要处理各种网页元素和动态加载的内容,对于更复杂的情况,您可能需要使用更高级的爬虫框架如Scrapy。

4、调试和优化代码:在编写完代码后,进行调试以确保代码能够正确抓取数据,如果遇到问题,可能需要调整代码以适应不同的网站结构,注意遵守网站的爬虫政策和使用条款。

5、数据存储和处理:一旦成功抓取数据,您需要将其存储到本地或数据库中,对数据进行清洗和预处理以便后续分析,这可以包括去除无关信息、格式化日期等。

6、数据分析与可视化:使用数据分析工具(如Python的Pandas库)进行数据处理和分析,根据需求进行可视化展示,例如使用Matplotlib或Seaborn库生成图表。

7、遵守法律和道德准则:在抓取数据时,请遵守相关法律和道德准则,尊重网站的使用条款和隐私政策,不要过度抓取或滥用数据。

四、总结

抓取往年12月14日的实时变化数据需要一定的技术和经验,通过本文的指导,您应该已经掌握了基本的方法和步骤,请务必在实际操作中遵守法律和道德准则,并持续学习和改进您的技能以适应不断变化的数据环境,希望本文对您有所帮助!

转载请注明来自首页,本文标题:《往年12月14日实时变化数据抓取指南,详细步骤与操作说明》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...